注意力机制——智能的必要而非充分条件

“术解”专题——从碎片化阅读中获得人工智能领域的“原来如此”

我们从问题出发,深入浅出地剖析,揭示原理,融入思考

往期:

01 核心问题

2017年,Google Brain团队发表了一篇改变AI格局的论文,其标题令人印象深刻:"Attention Is All You Need"(只需注意力就够了)。这篇论文宣告了一场技术革命——抛弃了此前主导的CNN和RNN架构,仅用注意力机制就构建了强大的Transformer模型,成为了今天几乎所有大语言模型的基础架构。

当初,论文的标题就旨在告诉自然语言处理领域不需要过去的那些架构,注意力机制仅仅只是作为它们(CNN、RNN)的补充。而是——仅仅注意力就足够了。

我对此标题有了更深层的联想——在哲学层面提出了一个假设:是否真的"只需注意力就足够了"?

当我们跳出纯粹的技术实现,站在更宏观的视角审视“智能”这一概念时,一个更深层次的问题油然而生:注意力机制,真的是我们构建通用人工智能所需要的全部吗?它在智能的版图中,究竟扮演着怎样的角色?

更具体地说,为什么我们可以认为注意力机制是智能的必要条件,却又不得不承认它并非充分条件?

02 注意力机制

我用一句话概括,注意力机制可以被定义(功能性)为:"在有限资源条件下,对信息重要性进行动态排序与整合的过程"。

当在嘈杂的环境,我们仍能够专注于交谈的那个人的声音,同时过滤掉其他对话。这就是人类的注意力机制在起作用。

AI领域的注意力机制,正是对这种认知能力的巧妙模拟。其核心思想可以概括为:根据当前任务的需要,动态地为输入信息的不同部分分配不同的“关注权重”,然后根据这些权重来聚合信息,生成更具表征力的输出。

注意力机制(核心与演化)

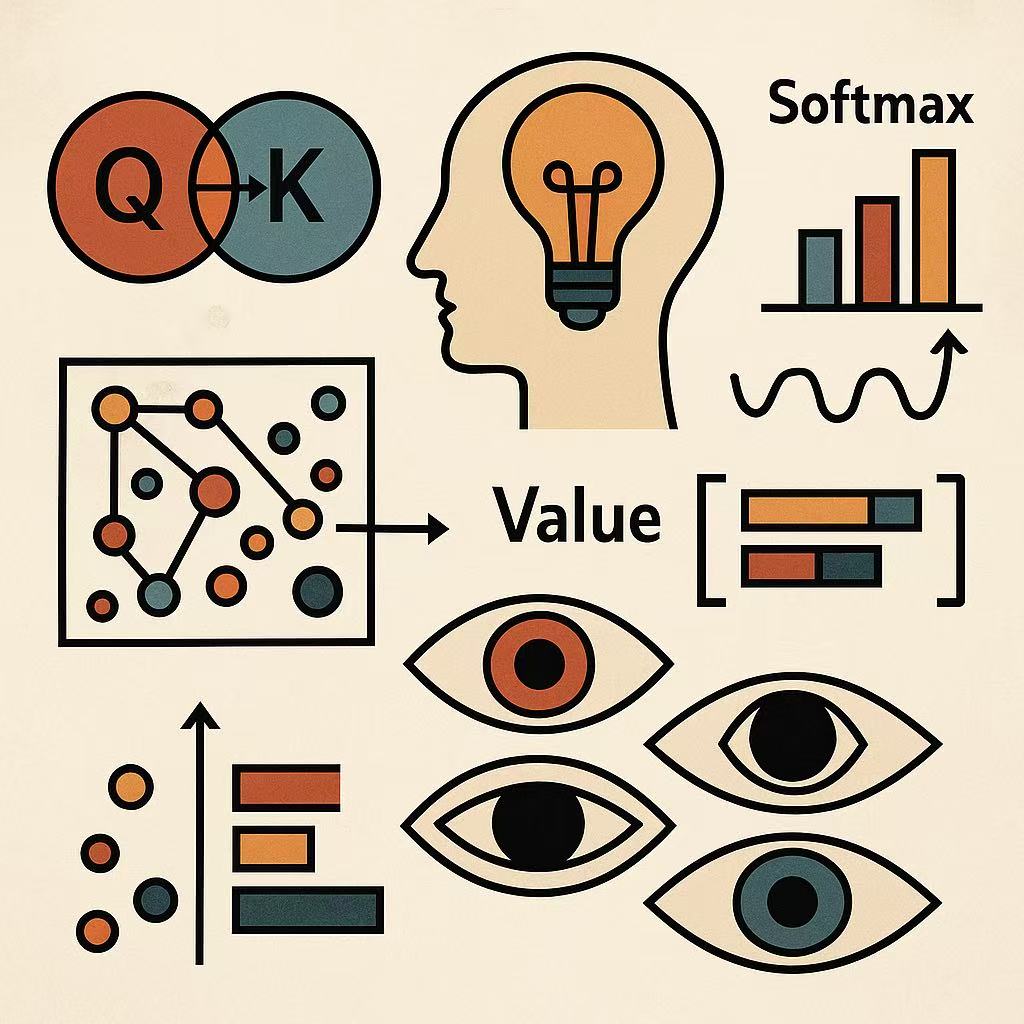

让我们抛开繁复的公式(除非必要),抓住Attention的核心骨架:

- Query (问询) - Q: “

我当前最关心什么?” (比如,在翻译“苹果”这个词时,模型想知道它是水果还是公司) - Key (关键字) - K: “

信息碎片里藏着的核心标签是什么?” (比如,句子中的其他词及其内在含义) - Value (值) - V: “

信息碎片的原始内容本身” (词向量或其他表示)

R1给出的易懂的核心运算流程(R1这次更新文字可读性很舒服):

相关性计算 (Q·K): 计算查询(Q)与各个关键字(K)的相关度(技术实现常是点积,衡量语义相似性)。这就像是你在图书馆里(上下文语境)拿着明确的搜索词(Q),逐一扫描每本书的关键标签(K),找出“标签匹配度”最高的书。注意力权重 (Softmax): 对所有相关度结果进行Softmax操作,将其归一化为概率分布(所有值在0-1之间,总和为1)。这一步意义重大:它本质上是对“相关度”进行资源分配的决策。最相关的得到最高的权重。继续图书馆的比喻:这一步就是基于匹配度高低,决定你将多少精力、时间投入到每一本找到的书上。匹配度极高的书占你绝大部分资源,一般的书快速略过,无关的书直接忽略(权重趋近于0)。加权融合 (∑权重·V): 用计算出的权重,对所有信息碎片的值(V)进行加权求和,得到最终的“上下文向量”。这代表在当前查询下,综合了所有相关信息并聚焦后的输出——你已经把有限的精力最有效率地分配给了那些最重要的书,并融合提炼出了你需要的关键信息。

对于注意力机制的演化方面,自注意力、因果注意力、多头注意力:

Self-Attention (自注意力): 当信息内部“自查互看”时,查询(Q)、关键字(K)、值(V)都来自同一个输入序列。这如同一个团队成员(词向量)“环顾四周”,理解队友(其他词)的角色和对当前任务(Query)的价值,最终达成更整体、连贯的理解。Causal Mask (因果掩码): 在生成任务(如写作)中限制未来信息的可见性(只关注“过去”的词),模仿人类的因果认知。Multi-Head Attention (多头注意力): 如同组成多个“注意力专家组”并行工作,每个组有不同的“关注视角”(通常通过映射到不同子空间实现)。最后汇总所有组的观察结论。这有效克服了单一视角的局限——同一段文本,一个组关注语法结构,一个组聚焦情感色彩,另一个捕捉指代关系…最后,一个更全面、多层次的“上下文理解”就被提炼出来了。

拆解到这里,你会发现:“注意力”的核心流程——匹配(筛选) -> 排序(权重分配) -> 聚焦(加权融合) -> 多视角(多头)——几乎完美契合了我们处理任何复杂信息时的底层需求。

这便是我想要表达的对于智能产生的必要性条件之一——注意力机制的重要阐述:

它本质上是一种极度聚焦的“认知经济学”:在无限的信息洪流中,如何用有限的计算资源(时间、算力、内存)获得最相关的价值?

注意力机制提供了一种动态、高效、可计算的资源分配方案,使“聚焦于关键信息”成为可能。没有了它,任何系统都将在信息混沌中迷失方向,智能无从谈起——这便奠定了其“必要性”的根基。

03 智能产生的必要性

我们进一步深挖。首先,我需要定义“智能”——完成某种复杂目标的能力。这是功能性的定义。

为什么如此简单的机制——仅仅只是点积匹配相似度,归一化计算权重,通过规模化就可以捕捉到我们语言中的逻辑关系——会成为智能系统的必要组成部分?

任何智能系统都必须面对一个普遍存在的挑战:资源有限性。无论是人脑的能量和神经带宽限制,还是计算机的内存和处理器约束,都无法同时处理环境中的全部信息。

因此,我认为:智能在资源受限环境下的本质需求是:在无限的信息洪流中,持续地、动态地、有选择地分配有限资源以建构意义。

注意力机制正是满足了这一核心需求:

1. 信息过滤

任何智能系统都面临一个根本挑战:信息过载。无论是生物神经网络还是人工神经网络,计算资源都是有限的。注意力机制提供了一种优雅的解决方案——动态过滤。

通过Query-Key匹配,系统能够识别出哪些信息与当前任务相关,哪些可以忽略。这不是静态的规则,而是根据具体上下文动态调整的。这种灵活性是完成复杂任务的前提。

2. 关系建模

智能的过程(进行完成复杂目标的任务)不仅仅是存储信息,更重要的是理解信息之间的关系。注意力机制的核心——计算不同元素之间的相关性——恰好捕捉了这一点。

在处理"国王之于男人,如同女王之于?"这类类比问题时,注意力机制能够识别出词语在高维语义空间中的相对位置关系。这种关系理解能力,是推理、类比、创造等高级认知功能的基础。

3. 上下文整合

单个词语的意义是贫瘠的,丰富的语义来自于上下文。注意力机制通过Value的加权组合,实现了上下文相关的意义建构。

同一个词"苹果",在"我吃了一个苹果"和"我买了一部苹果手机"中有完全不同的含义。注意力机制让每个词都能够根据周围的词动态调整自己的表示,这种上下文敏感性是语言理解的核心。

4. 资源优化

从更抽象的层面看,注意力机制体现了一个深刻的原则:在资源受限的条件下,通过优化分配实现最大效能。这或许是所有智能系统的共同特征。

无论是生物进化还是技术发展,成功的系统都不是那些试图处理所有信息的,而是那些懂得聚焦、懂得取舍的。注意力机制将这种智慧编码成了可计算的形式。

注意力机制产生智能,对于解决技术的角度这里不去展开了,简单说还解决了传统序列模型(RNN)的痛点:长程依赖(注意力能够访问任何位置)、并行计算等等。

注意力机制的最美妙之处在于它的简单性与通用性。仅仅通过向量点积和加权和这样基础的数学操作,它就能构建出语义空间中的丰富关联。就像爱因斯坦所追求的那样:"尽可能简单,但不能过于简单"——注意力机制似乎恰好找到了这一平衡点。

04 必要而非充分

尽管注意力机制如此强大,但仅凭它还不足以构成完整的智能。让我们理性地审视它的局限。

1. 关于记忆

这也是当今AI需要解决的很大的一个问题。

注意力机制本质上是一种即时计算——它在当前上下文中动态分配权重,但不具备真正的长期记忆。虽然Transformer可以处理很长的序列,但这种"记忆"是被动的、无结构的。

相比之下,人类智能拥有复杂的记忆系统:工作记忆、情景记忆、语义记忆、程序性记忆等。这些不同类型的记忆相互协作,支撑起我们的认知能力。

2. 关于主动

发挥主观能动性,仍然会有很重要的意义。

前面我们说过,功能性定义“智能”— 完成某种复杂目标的能力——智能行为通常是目标导向的。

虽说我们能够为AI下达目标与任务,会在强化学习中加入奖励信号,但那均是外部赋予的目标,而非系统自主生成的。这种主动性的缺失,限制了基于注意力的系统达到更高层次的智能。

3. 关于理解

当今AI界争议最大的话题,“ta到底有没有理解?理解又是什么?”

这或许是最深层的问题:注意力机制处理的是符号之间的关系,而非符号背后的意义。它可以完美地模拟语言使用,却可能对语言所指涉的现实世界一无所知。

这就是著名的"中文房间"悖论——一个完美遵循规则处理中文的系统,是否真的"理解"中文?注意力机制面临同样的质疑。

在我们认识到注意力机制后,我对更高“智能”的展望:

Attention + 记忆(结构化记忆系统,当今一些研究已经取得进展)+ 世界模型(物理、因果、社会等模型,建构出多模态理解,仍处于研究前沿)+主动学习(可以给出大方向,但不能具体设置目标,引导主动学习)

05 原来如此

回到最初的问题:为什么注意力机制是智能的必要条件,却不是充分条件?

原来,智能不是单一机制的产物,而是多种认知能力的协同涌现。 注意力机制抓住了其中一个关键维度——在有限资源下动态分配注意力以建构意义。这种能力如此基础,以至于任何智能系统都离不开它。

但智能的完整图景远比这丰富。它需要记忆来积累经验,需要目标来驱动行为,需要理解来连接符号与现实。

Transformer的成功告诉我们,仅凭注意力机制就能走得很远——远到足以改变世界。但它的局限也提醒我们,通向真正智能的道路还很长。

这也是我对"Attention Is All You Need"这句话的重新理解——它不是终点,而是一个激动人心的起点。

或许,"Attention Is All You Need"这个标题最大的价值,不在于它宣告了注意力的充分性,而在于它让我们意识到:简单的机制,在适当的规模和数据下,能够涌现出惊人的复杂性。 这给了我们希望——也许智能的秘密,就藏在这些看似简单的原理之中。

而作为在AI时代思考和学习的我们,或许也需要培养自己的"注意力"——在信息的洪流中,持续地、动态地、有选择地关注真正重要的东西。毕竟,无论是机器智能还是人类智能,注意力的分配,就是认知资源的分配,就是我们与世界互动的方式。